Pythonではimportというそうです。輸入。

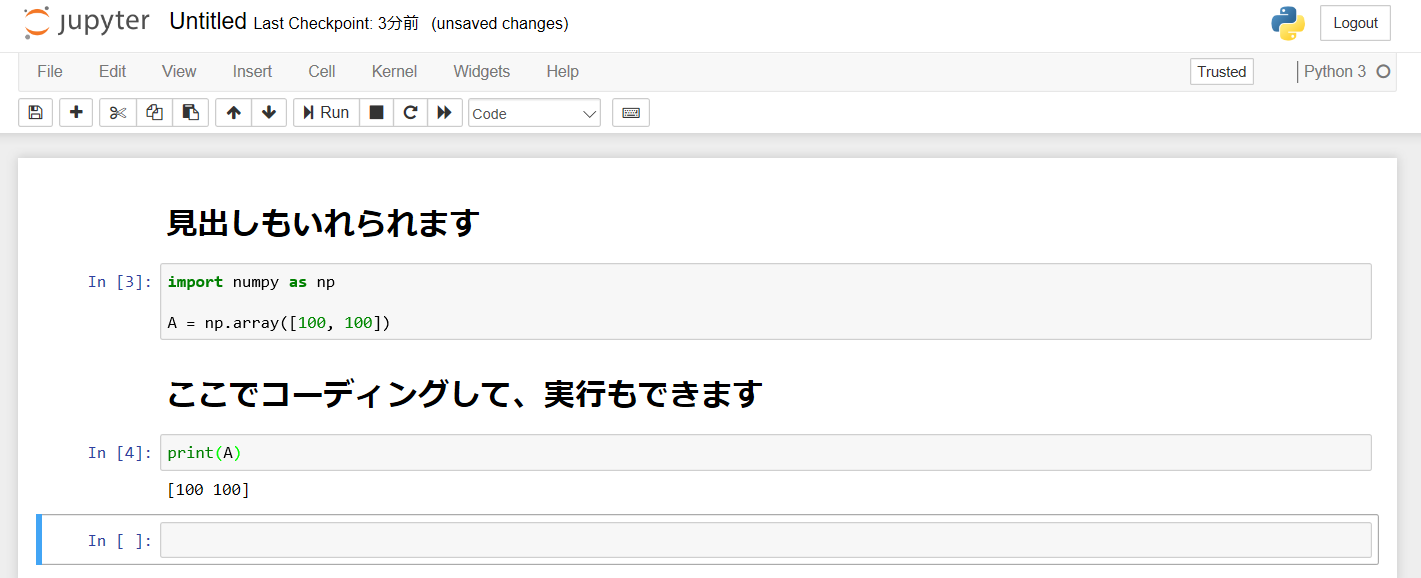

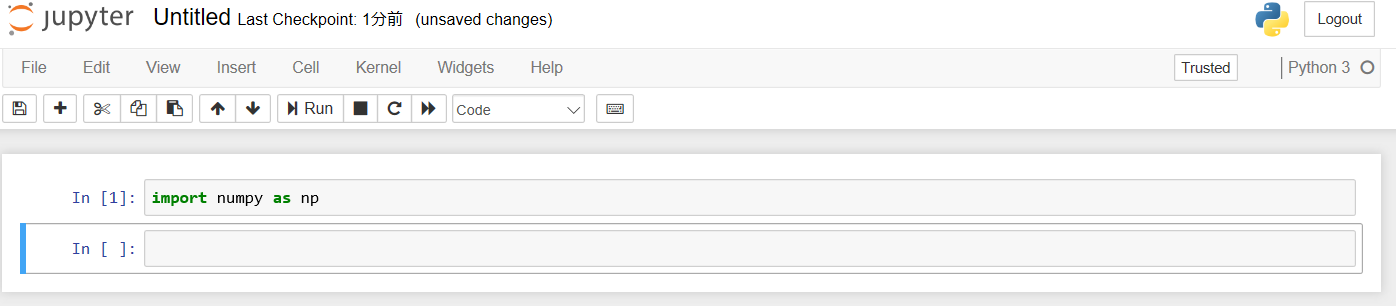

まずはnumpyをインクルードしてみます。

numpyは行列計算を実行する時に使うライブラリです。

ノートブックを開き、下記のように打ち込んで、Runをクリック。

特にエラーがでなければimport成功です。

もしエラーがでるようであればnumpyがPCにインストールされていないようです。

その場合はプロンプトを開き、下記のコマンドでインストールできます。

pip install numpy

同じ感じでグラフを扱うときはMatplotlib、データ解析の時はPandasなどをimportしていきます。

また自分で作ったクラスも同じ感じでimportして使います。

from common.mycode import mydefinedclass

commonフォルダにある、mycode.pyファイルの中で定義されているmydefinedclassをimportするよ、という意味になります。

自分でclassを実装して行って、実行ファイルではそれを読み込んで実施する、といった流れになります。